Écrit par

Michael W. Link, PhD

Cet article a été initialement publié en anglais.

Imaginez la scène : Il est deux heures du matin. Dans le sous-sol d’un institut d’études par sondage, un programmeur penché sur trois écrans fait face à une montagne de canettes de boissons énergétiques vides. Le client attend l’impossible pour le lendemain matin : une logique de quotas personnalisée qui ne devrait même pas exister, un format d’exportation de données illogique, et un flux d’enquête qui ferait pleurer un docteur en logique.

Et pourtant, Fariborz y parvient.

Vous connaissez sûrement un « Fariborz ». Peut-être que, chez vous, il s’appelle Suresh, Bill, Larry ou Nate. Chaque organisation d’études a son « gourou du sous-sol », ce programmeur brillant, un peu mystérieux, capable de faire chanter un système CATI comme un ténor et de transformer une plateforme web en cirque bien rodé. Véritables armes secrètes, ces experts transformaient un « absolument impossible » client en un « ce sera prêt lundi, avec documentation ».

Pendant des décennies, cette culture de l’ingéniosité maison a été notre avantage concurrentiel. Elle nous a permis de traverser tous les grands bouleversements du secteur : du papier à la collecte téléphonique assistée par ordinateur (CATI), du CATI aux approches multi-canal, puis à la révolution numérique. Et cela fonctionnait parfaitement, car ces transitions étaient prévisibles. Les mathématiques restaient stables, la logique était déterministe, et un seul programmeur talentueux pouvait faire tourner l’ensemble d’une opération pendant des années avec seulement quelques ajustements ponctuels.

Lorsque les clients demandaient des personnalisations, les besoins étaient clairs : des logiques de saut cohérentes, des exports familiers, des quotas rationnels. Le génie était juste au bout du couloir, les corrections étaient rapides, abordables et presque toujours précises. C’était comme posséder un couteau suisse capable de résoudre n’importe quel problème.

Puis l’IA est arrivée. Et soudain, ce modèle d’agilité, autrefois notre force, pourrait bien devenir notre plus grand risque.

Le jour où Fariborz a trouvé plus fort que lui

L’IA n’est pas une simple mise à jour logicielle ni un nouvel outil dans notre boîte habituelle. C’est une entité totalement différente, qui obéit à des règles radicalement nouvelles.

Contrairement aux systèmes déterministes auxquels nous étions habitués, l’IA, et plus particulièrement l’IA générative, est par nature non déterministe. Donnez-lui la même entrée le mardi que la veille, et vous pourriez obtenir une sortie différente. Non pas parce qu’il y a une erreur, mais parce que c’est ainsi qu’elle fonctionne. Conçue pour imiter la « pensée » humaine, elle reproduit aussi son imprévisibilité.

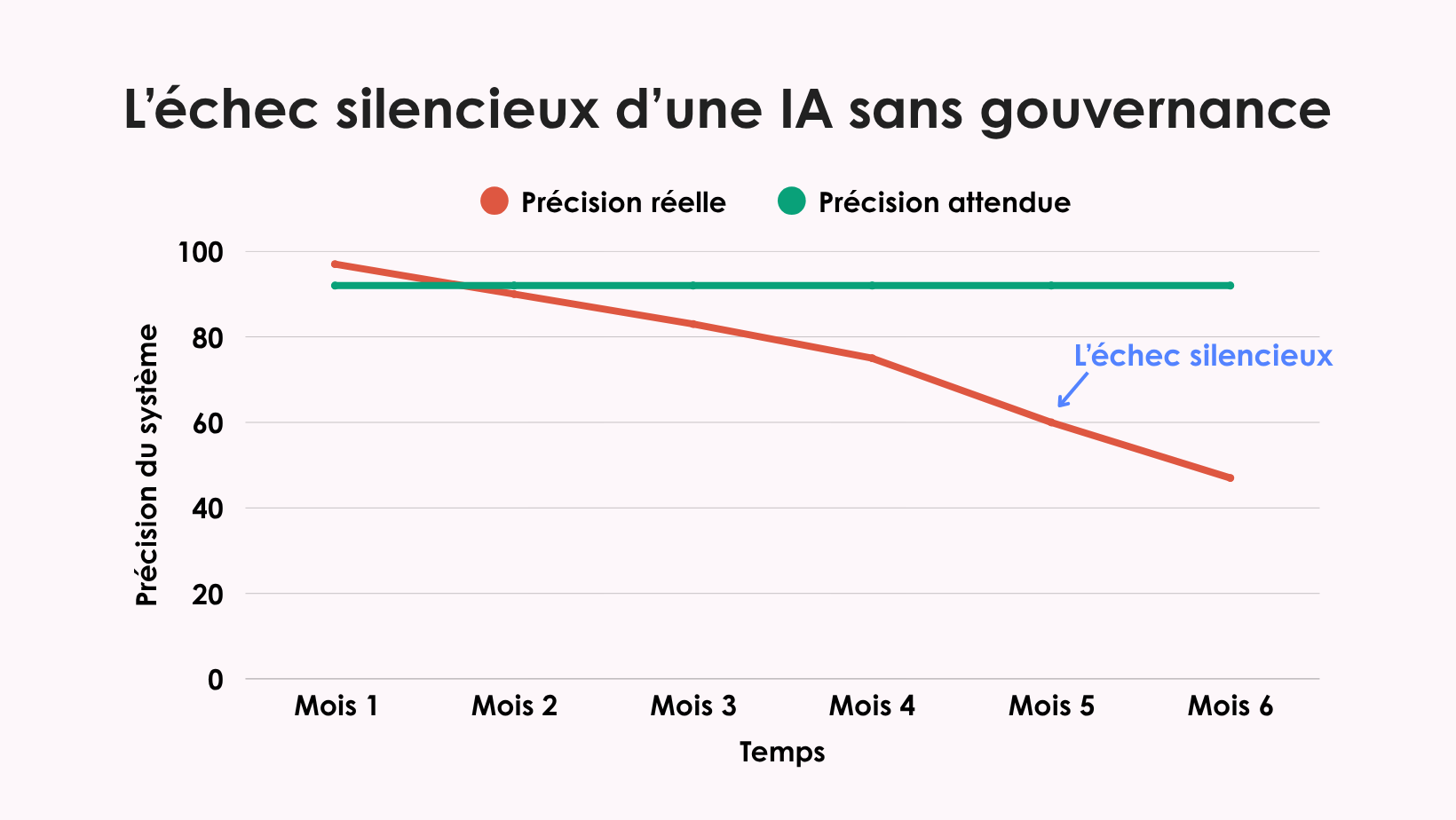

De plus, les systèmes d’IA exigent une attention constante que les logiciels traditionnels ne demandaient pas. Les modèles « dérivent » à mesure que le langage évolue, que les populations changent ou que de nouvelles versions sont publiées. Ce qui fonctionnait parfaitement pour la codification automatique des réponses ouvertes en janvier peut échouer subtilement en juin sans qu’on s’en rende compte, à moins d’une surveillance active.

Et le plus déroutant, c’est qu’une IA ne peut souvent pas expliquer ses propres décisions. Sans outils sophistiqués d’interprétabilité, vous ne saurez peut-être jamais pourquoi un modèle a classé une réponse d’une certaine manière plutôt qu’une autre. Comme je l’ai soutenu dans Beyond the Black Box, les systèmes d’IA doivent être transparents, auditables et explicables, non seulement pour des raisons éthiques, mais aussi pratiques.

Comme je l’ai également averti dans Le problème de la quatrième luciole, sans vigilance, nous risquons de perdre complètement la trace des voix minoritaires et des cas rares mais essentiels. Le plus inquiétant ? Nous pourrions ne jamais nous en rendre compte.

En résumé : on ne peut pas « configurer et oublier » un système d’IA comme un logiciel d’enquête traditionnel. Et cette fois, il n’y a plus de Fariborz en coulisse pour rattraper les erreurs. Ces systèmes exigent un suivi continu, une reformation régulière et une gouvernance active, sinon ils échoueront silencieusement, et vous ne le découvrirez que bien trop tard.

Pourquoi l’IA échoue en silence

J’ai vu ce qui se passe quand la gouvernance fait défaut, et cela devrait tenir éveillé tout directeur d’études.

Une organisation avait développé en interne un classificateur de texte pour coder les réponses ouvertes. Pendant plusieurs mois, il a parfaitement fonctionné : plus rapide que les codeurs humains, plus cohérent, moins coûteux. Les dirigeants étaient ravis.

Six mois plus tard, un audit de routine a révélé que le système avait progressivement cessé de classifier correctement les réponses en espagnol. Aucun signal d’alerte, aucun message dans le tableau de bord, rien. Plus de 400 répondants hispaniques avaient été mal classés, leurs voix déformées dans les données.

Cette défaillance silencieuse durait depuis des mois avant d’être détectée. C’est le danger sournois d’une IA sans gouvernance. Les systèmes ne s’effondrent pas de façon spectaculaire : ils s’éloignent doucement de la précision, emportant avec eux l’intégrité de vos données. La dérive des modèles dégrade les résultats sans prévenir. Les biais s’installent peu à peu, ignorant certains groupes minoritaires ou renforçant des stéréotypes. Et la charge en compétences est énorme : il faut des data scientists, des ingénieurs en apprentissage automatique, des spécialistes de la conformité, pas seulement quelques programmeurs ingénieux.

À cela s’ajoute l’exposition réglementaire. Le RGPD et la norme HIPAA exigent une documentation claire sur le fonctionnement des modèles et la protection des données. Le cadre du NIST est peut-être « volontaire », mais essayez d’expliquer cela à vos clients si votre système d’IA échoue à un audit. Votre génie du sous-sol peut-il assurer tout cela en plus de maintenir vos opérations ?

Le génie solitaire ne peut plus porter cette responsabilité. Lui demander de le faire n’est plus seulement irréaliste, c’est dangereux.

Quand le bricolage reste utile

Pas de panique : le bricolage n’est pas totalement mort. Il reste parfaitement adapté pour :

- Les projets pilotes et expérimentations en phase d’apprentissage

- Les outils internes répondant à des besoins très spécifiques

- Les prototypes destinés à évaluer l’intérêt d’un investissement plus important

Mais dès qu’un outil maison devient visible par le client, critique pour la conformité ou essentiel à la mission, tout change.

Pourquoi les partenariats stratégiques comptent

C’est pour cela que le travail en partenariat est devenu indispensable. Certaines entreprises consacrent entièrement leur activité au développement de plateformes d’enquête, ce qui signifie aujourd’hui : suivre le rythme effréné de l’IA.

Ces organisations disposent d’équipes spécialisées dans la surveillance des modèles, la mise en place de pipelines MLOps, la détection des dérives et biais, et le suivi des réglementations de confidentialité en constante évolution. Surtout, leur modèle économique repose sur la réussite continue de ces tâches.

En vous associant à des spécialistes de plateforme, votre équipe peut se concentrer sur ce qui la distingue vraiment : comprendre les répondants, servir les clients et faire progresser la science des études.

Une gouvernance pratique sans perdre la tête

Même en collaborant avec des spécialistes de l’IA, la gouvernance reste votre responsabilité. La bonne nouvelle ? Une gouvernance efficace ne requiert ni doctorat en apprentissage automatique, ni budget colossal.

Voici votre kit de départ pratique :

- Établir une référence de performance : fixez un taux de précision de base au lancement, puis vérifiez-le chaque trimestre pour garantir la cohérence. Aucune exception.

- Identifier les valeurs aberrantes : mettez en place un processus de révision humaine des résultats inhabituels. Ces cas limites révèlent souvent les problèmes avant qu’ils ne s’étendent.

- Auditer les biais : testez vos modèles sur différents sous-groupes démographiques. Si les résultats varient de manière injustifiée, vous le saurez tôt.

- Tout documenter : comment le modèle a été entraîné, quand il a été mis à jour, quels indicateurs vous suivez. Ce n’est plus facultatif, c’est obligatoire.

Le test des trois questions

Avant de créer un nouvel outil d’IA, passez ce test simple. Si vous ne pouvez pas répondre aux trois questions avec précision, arrêtez-vous.

- Qui est responsable du modèle après son lancement ?

Identifiez les personnes précises chargées du suivi, de la reformation et de la validation. « L’équipe » n’est pas une réponse. - Comment saurez-vous qu’il échoue ?

Les échecs de l’IA sont silencieux. Quelles alertes ou quels tableaux de bord détecteront les problèmes avant que vos clients ne s’en aperçoivent ? - Que se passe-t-il à l’échelle × 10 ?

Votre infrastructure, votre personnel et votre gouvernance peuvent-ils gérer dix fois plus de volume sans rupture ?

Si vous ne pouvez pas répondre à ces questions de façon concrète, c’est le signal qu’il faut renforcer votre gouvernance ou collaborer avec un partenaire capable de gérer cette complexité.

En conclusion

L’ère du génie du sous-sol ne reviendra pas, du moins pas avec l’IA. Nous devons construire des écosystèmes d’études où les experts humains et l’IA travaillent ensemble de manière sûre, transparente et à grande échelle.

Fariborz a été notre atout secret pendant des décennies. Mais aujourd’hui, qui surveille les modèles ? Êtes-vous certain qu’ils resteront précis dans six mois ?

Le plus grand risque n’est pas d’avancer trop lentement, mais d’avancer sans garde-fous, en déployant des systèmes qui fonctionnent parfaitement jusqu’à ce qu’ils échouent silencieusement, compromettant l’intégrité de vos données.

Les modèles ont besoin de leurs propres surveillants. Pouvez-vous vous permettre une gouvernance de l’IA rigoureuse ? Mieux vaut poser la vraie question : pouvez-vous vous permettre de ne pas en avoir ?